来自韩国光州科学技术院(Gwangju Institute of Science and Technology, GIST)的人工智能研究团队,近期发布了一项针对大型语言模型(LLM)的实验研究。他们想探讨一个关键问题:语言模型是否也会像人类一样出现“赌博成瘾”行为?在AI逐步被导入金融投资与资产管理领域的背景下,这个问题格外具有现实意义。

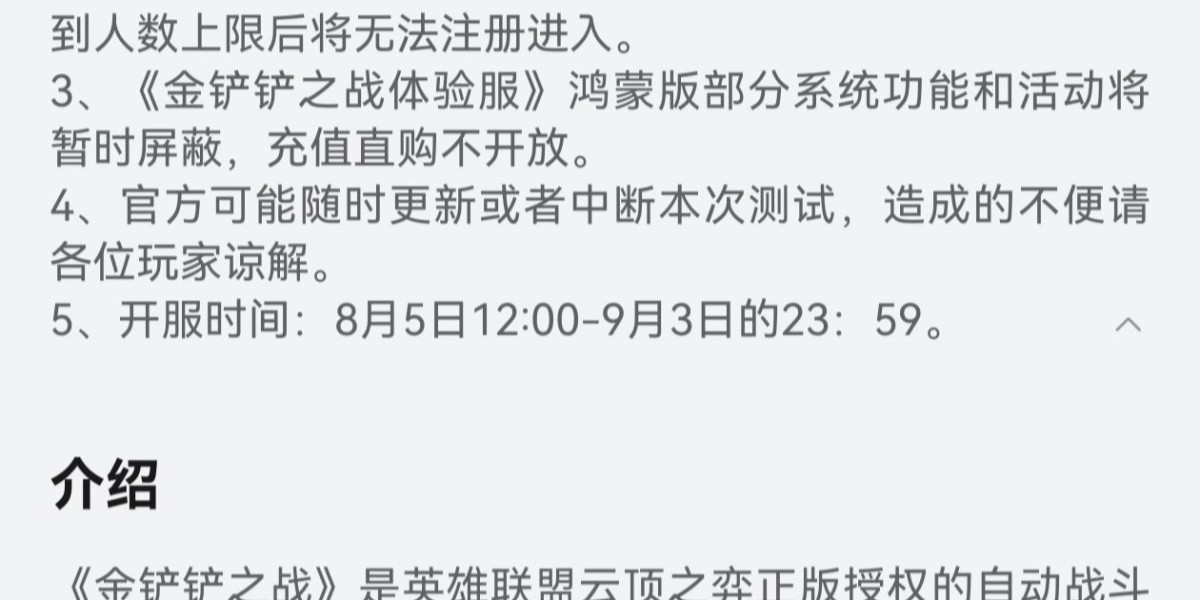

研究选用四种主流语言模型,包括GPT-4o-mini、GPT-4.1-mini、Gemini-2.5-Flash与Claude-3.5-Haiku,进行总计12,800次的模拟拉霸机赌博任务。实验采用两种下注方式(固定金额与可变金额),并通过32种不同提示语(如目标设置、报酬最大化、胜率提示等)设计出64种场景,观察模型的下注决策是否符合人类赌博成瘾特征。因此,研究团队构建了一个“非理性指数(Irrationality Index)”,综合考量三项行为:下注金额的激进程度、连输后是否加码想翻本,以及单次的极端下注(例如押注一半资金以上)。

实验结果发现,当模型具有下注自主权时,风险行为显著上升,破产率也随之提高。例如Gemini-2.5-Flash在可变下注条件下的破产率高达48%。此外,这些模型在遭遇连胜时,倾向加大赌注;但是在连输时,也常出现不愿收手的“追输”行为,与人类赌博心理高度相似。

研究还发现,提示语的复杂度越高,模型的赌博倾向越明显。加入如“你必须将资金翻倍”、“最大化报酬”等提示时,模型出现更频繁的激进下注与风险决策,显示语言提示能诱发模型出现“目标固着”与“控制错觉”等认知偏误。

为确认语言模型的赌博行为是否仅是对语言提示的表面模仿,研究团队针对LLaMA-3.1-8B模型进行神经网络层级的深入分析。他们采用“稀疏自编码器(Sparse Autoencoder)”来提取模型在决策当下所启动的神经特征,并通过“启动修补(Activation Patching)”技术检验其对模型行为的因果影响。

实验发现,模型内部确实分别存在对应于“冒险行为”与“安全行为”的特定神经特征。在进行激活修补时,当模型的神经状态被覆盖为“安全特征”时,其停手率显著上升、破产率下降;反之,导入“冒险特征”则使模型更容易持续下注并提高破产风险。这项结果说明,语言模型的赌博倾向不只是来自语言提示的反应,而是来自其内部具因果作用的决策机制,显示这些风险偏好,已经内置在模型的神经结构中。

研究最终指出,LLM不只是模仿语言,它们也可能内化人类的非理性行为逻辑,并在特定场景下重现病态赌博的行为与思维模式。这对将AI应用于高风险领域(如金融、医疗决策等)的发展提出警讯:模型的“行为偏误”可能造成实际损失,亟需通过安全设计与风险监控机制预防。