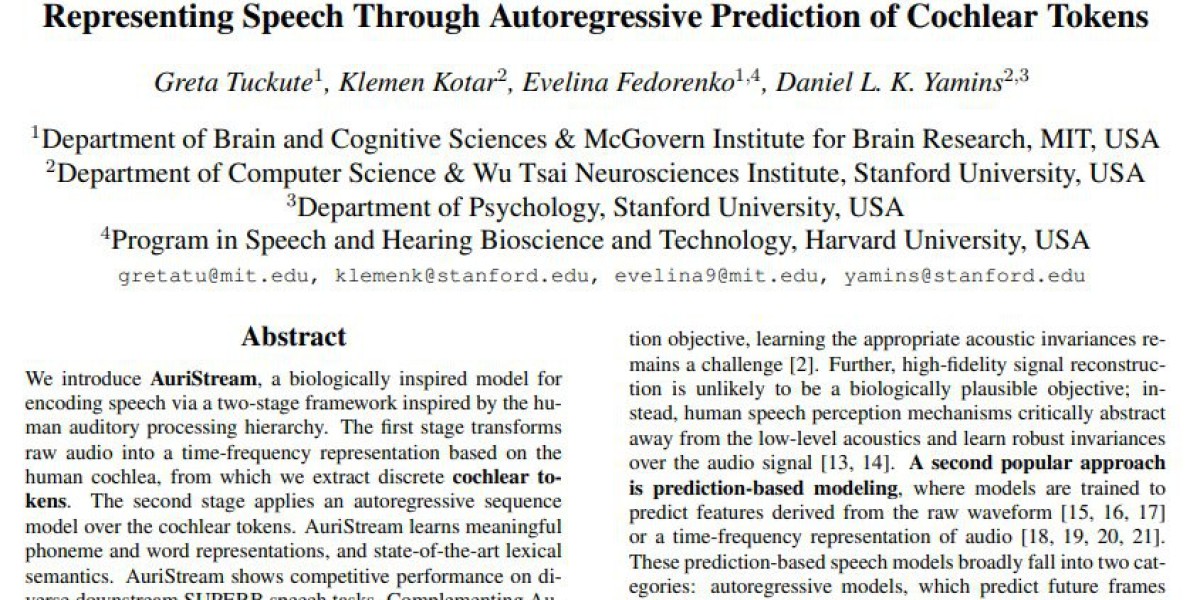

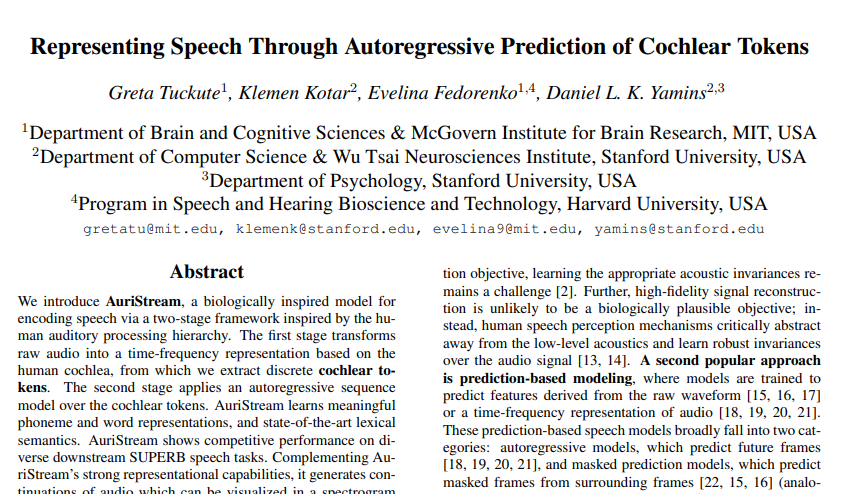

这项由MIT脑与认知科学系的Greta Tuckute以及斯坦福大学计算机科学系的Klemen Kotar、Daniel L. K. Yamins等研究者共同完成的突破性研究,发表于2025年8月的arXiv预印本平台。有兴趣深入了解的读者可以通过arXiv:2508.11598v1访问完整论文。

说起人类的听觉系统,那真是一个令人惊叹的生物工程奇迹。我们能够在嘈杂的咖啡厅里轻松分辨出朋友的声音,能够从语调中听出说话人的情绪变化,甚至能够在听到一个陌生单词时大致猜出它的含义。然而,让人工智能系统达到人类这样的听觉理解能力,却是一个让科学家们头疼了很久的难题。

传统的AI语音处理系统就像是一个只会机械记忆的学生,它们要么专注于完美地复制原始音频信号的每一个细节,要么依赖复杂的对比学习机制来区分不同的声音片段。这些方法虽然在某些特定任务上表现不错,但却缺乏人类听觉系统那种灵活性和适应性。更重要的是,这些系统往往像黑匣子一样难以解释,我们很难理解它们究竟是如何"听懂"声音的。

MIT和斯坦福的研究团队决定从根本上改变这种思路。他们没有继续在传统方法上修修补补,而是回到了最初的起点:人类的耳朵是如何工作的?这个看似简单的问题,却为他们开启了一扇全新的大门。

研究团队发现,人类的听觉处理过程实际上可以分为两个关键阶段。第一个阶段发生在我们的内耳,那里有一个叫做耳蜗的螺旋状结构,它就像一个精密的频谱分析仪,将声波转换成不同频率的神经信号。第二个阶段则发生在大脑中,神经网络会对这些信号进行进一步的处理和理解,最终形成我们对声音的认知。

受到这一生物机制的启发,研究团队设计了一个名为AuriStream的革命性AI系统。AuriStream这个名字本身就很有意思,"Auri"来自拉丁语中的"听觉",而"Stream"则表示连续的数据流,寓意着这个系统能够像人类一样连续地处理和理解声音信息。

AuriStream的工作方式确实很像人类的听觉系统。首先,它有一个叫做WavCoch的组件,这个名字结合了"Wave"(声波)和"Cochlea"(耳蜗)两个词。WavCoch就像人工耳蜗一样,能够将原始的音频波形转换成一种特殊的时频表示,研究人员称之为"cochlear tokens"(耳蜗令牌)。这些令牌就像是声音的"基因片段",每个片段都包含了声音在特定时间和频率上的信息。

接下来,AuriStream的第二个组件会接手这些耳蜗令牌。这个组件采用了一种叫做"自回归序列建模"的技术,听起来很复杂,但实际上它的工作原理就像一个聪明的故事接龙游戏。给定前面的声音片段,系统会预测下一个最可能出现的声音片段是什么。通过这种方式,系统逐渐学会了声音的内在规律和模式。

这种设计的妙处在于,它不仅模仿了人类听觉系统的生理结构,更重要的是,它采用了一种生物学上合理的学习方式。人类婴儿学习语言时,也是通过不断地听和预测来掌握语音规律的。当一个孩子听到"妈妈"这个词的前半部分"妈"时,他很可能会预期接下来听到另一个"妈"。AuriStream的学习过程与此类似,只不过它处理的是更加精细的声音特征。

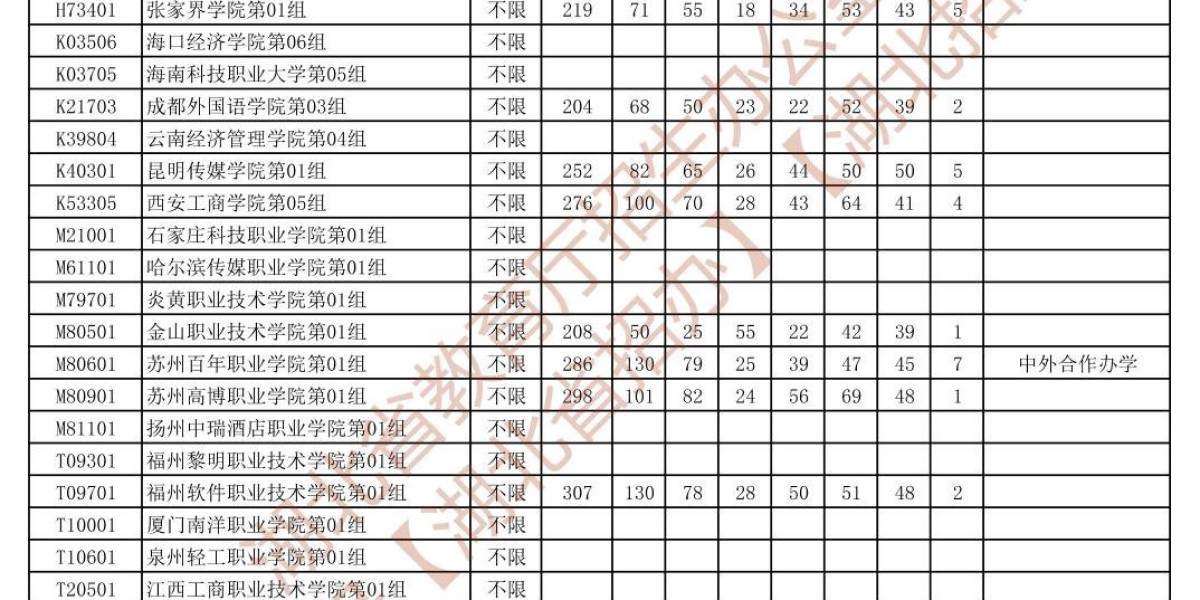

研究团队开发了两个版本的AuriStream:一个拥有约1亿个参数(AuriStream-100M),另一个则拥有近10亿个参数(AuriStream-1B)。这里的参数就像是系统的"神经连接",参数越多,系统的学习和理解能力就越强。为了训练这些模型,研究人员使用了LibriLight数据集,这是一个包含6万小时英语语音的庞大语料库,相当于一个人连续说话近7年的内容。

那么,AuriStream的表现究竟如何呢?研究结果让人印象深刻。在识别语音中的音素(构成语言的最小声音单位)方面,AuriStream-1B的准确率达到了88%,这个成绩已经非常接近目前最先进的HuBERT和WavLM模型的表现。更令人惊喜的是,在词汇语义理解方面,AuriStream创造了新的纪录。

词汇语义理解是什么意思呢?简单来说,就是系统能否理解不同词汇之间的意义关系。比如,"水"和"河流"在意义上是相关的,而"节日"和"胡须"则毫无关系。研究人员使用了一个叫做sSIMI的基准测试,这个测试会给出成对的单词,然后比较人类对这些词汇相似度的判断与AI系统的判断是否一致。

在这个测试中,AuriStream-1B取得了惊人的成绩。在自然语音数据上,它的得分达到了12.52分,而在合成语音数据上得分为10.64分。要知道,之前的最佳模型WavLM-large在相应测试中的得分分别是10.50和10.37。这意味着AuriStream不仅能够准确识别语音,更重要的是,它真正"理解"了词汇的含义。

研究团队还在SUPERB基准测试上验证了AuriStream的综合能力。SUPERB就像是语音AI领域的"高考",包含了15个不同的任务,涵盖了语音处理的各个方面:内容理解、说话人识别、语义分析、情感识别和语音生成等。在这些测试中,AuriStream-1B在自动语音识别、意图分类和语音分离等任务上都表现出色,证明了它作为通用语音理解系统的潜力。

AuriStream最令人兴奋的特性之一,是它的可解释性。传统的AI语音系统往往像黑匣子一样,我们很难理解它们的决策过程。但AuriStream不同,由于它的预测结果可以转换回可视化的声谱图,我们实际上可以"看到"系统在预测什么样的声音。

研究人员进行了一系列有趣的实验来展示这一特性。他们给AuriStream播放某个单词的开头部分,然后观察系统会如何"续写"这个单词。结果发现,当给定"she"这个词的开头音素"sh"时,系统能够一致地预测出后面的"e"音,从而完整地生成"she"这个词。更有趣的是,当给定一个可能对应多个单词的开头音素时(比如"wa"可能是"water"或"wash"的开始),系统会生成不同的合理续写,显示出它确实掌握了语音的统计规律。

在更长时间尺度的预测中,AuriStream展现出了类似人类的行为模式。当给定2.5秒的语音提示后,系统能够生成几秒钟的合理续写,这些续写在内容上与原始提示相关,但随着时间的推移会逐渐偏离。这种现象实际上很符合人类的认知特点:我们在进行语音预测时,短期预测通常很准确,但长期预测的不确定性会增加。

AuriStream的训练方式也体现了研究团队对生物合理性的追求。与那些需要同时对比数百或数千个样本的对比学习方法不同,AuriStream只需要根据前文预测下一个声音片段,这种学习方式更接近人类和其他动物的自然学习过程。毕竟,在现实世界中,大脑并不能同时访问成千上万个声音样本进行对比,而是通过序列化的经验积累来学习语音规律。

从技术实现的角度来看,WavCoch模块采用了一种巧妙的编码-解码架构。编码器由8层一维卷积构成,每层都像一个特殊的滤波器,能够提取声音在不同时间尺度上的特征。在编码器的输出和解码器的输入之间,研究人员放置了一个13位的LFQ(Lookup-Free Quantization)瓶颈层。这个瓶颈层就像一个"信息压缩器",将连续的音频特征离散化为8192个可能的"耳蜗令牌"之一。

这种离散化处理的好处是多方面的。首先,它大大减少了需要处理的信息量,使得后续的序列建模变得更加高效。其次,离散的表示更适合Transformer架构的处理,因为Transformer最初就是为处理离散符号序列(如文本中的单词)而设计的。最后,离散表示使得系统的预测结果更容易解释和分析。

AuriStream的主体模型采用了类似GPT的Transformer架构,这是目前在自然语言处理领域最成功的模型结构之一。AuriStream-1B版本包含48层Transformer块,每层有16个注意力头和1280维的嵌入空间。这种大规模的参数配置使得模型能够捕捉语音中的复杂模式和长距离依赖关系。

训练过程中,研究团队使用了AdamW优化器,这是Adam优化器的改进版本,在处理大规模Transformer模型时表现更加稳定。学习率设置为3×10^-4,并采用了余弦退火调度策略,这种策略能够帮助模型在训练后期更好地收敛到最优解。

研究团队在多个维度上验证了AuriStream的性能。在音素识别任务中,他们使用TIMIT数据集进行测试,这是语音识别领域的经典基准数据集。测试结果显示,AuriStream不仅整体准确率高,其错误模式也很合理。例如,系统经常将"er"音误识别为"r"音,或将"ah"音误识别为"ih"音,这些错误在语音学上都是可以理解的,因为这些音素在声学特征上确实比较相似。

在词汇语义理解方面,AuriStream的优异表现可能源于其独特的训练方式。传统的语音表示学习模型往往专注于声学特征的建模,而忽视了语义信息。但AuriStream通过预测序列中的下一个元素,自然地学会了语音和语义之间的关联。当系统预测"river"这个词后面可能出现的声音时,它需要理解这个词的语义,才能做出合理的预测。

值得注意的是,AuriStream的成功并不依赖于复杂的工程技巧或数据增强方法。与WavLM等模型不同,AuriStream没有使用噪声注入、掩码预训练或聚类分析等复杂技术。它的优异性能主要来自于生物启发的架构设计和简单而有效的自回归学习目标。这种简洁性使得AuriStream更容易理解、实现和改进。

研究团队还探索了AuriStream在不同规模下的性能表现。从AuriStream-100M到AuriStream-1B,随着参数量的增加,模型在各项任务上的性能都有明显提升。这种良好的缩放特性表明,通过进一步增加模型规模和训练数据,AuriStream很可能取得更好的性能。

从计算效率的角度来看,AuriStream的设计也很有优势。传统的音频处理通常需要处理16kHz或更高采样率的原始波形,数据量庞大。而AuriStream的耳蜗令牌表示将音频压缩到每秒约200个令牌,这大大减少了计算负担。同时,这种压缩率仍然保留了语音理解所需的关键信息。

研究的另一个亮点是对模型可解释性的深入探索。通过将预测的耳蜗令牌转换回声谱图,研究人员能够直观地观察模型的预测过程。这种可解释性不仅有助于理解模型的工作机制,也为未来的改进提供了方向。

在实际应用前景方面,AuriStream展现出了巨大的潜力。它可以作为各种语音处理任务的基础模型,包括语音识别、情感分析、说话人识别等。更重要的是,由于其生物启发的设计,AuriStream可能为开发更加自然和直观的人机交互系统提供基础。

研究团队也诚实地讨论了当前工作的局限性。AuriStream目前只在英语语音上进行了训练和测试,其在其他语言上的表现还有待验证。此外,训练数据主要来自朗读语音,在处理自然对话或带有强烈口音的语音时可能面临挑战。这些限制为未来的研究指明了方向。

从更广阔的科学视角来看,AuriStream的成功验证了生物启发方法在人工智能研究中的价值。通过深入理解人类听觉系统的工作原理,研究人员能够设计出更加有效和可解释的AI系统。这种方法论可能对其他感知模态(如视觉、触觉)的AI研究也具有借鉴意义。

AuriStream的开源也体现了研究团队对开放科学的承诺。他们不仅公开了模型权重,还提供了详细的实现细节和训练代码,这将大大推动相关研究的发展。其他研究者可以基于AuriStream进行进一步的研究,探索不同的应用场景和改进方向。

说到底,AuriStream代表了语音AI研究的一个重要里程碑。它不仅在性能上达到了新的高度,更重要的是,它为我们提供了一个全新的思考框架:如何通过模仿生物系统的智慧来设计更好的AI系统。这种生物启发的方法,结合简洁的学习目标和强大的模型架构,可能将开启语音AI研究的新篇章。

对于普通人来说,AuriStream的成功意味着我们离真正智能的语音助手又近了一步。未来的语音AI系统可能不仅能够准确识别我们说的话,还能理解我们话语中的深层含义,甚至预测我们接下来可能说什么。这将为智能家居、教育辅助、医疗诊断等领域带来革命性的变化。同时,AuriStream的可解释性也为AI系统的安全性和可信度提供了保障,让我们能够更好地理解和控制这些智能系统的行为。

Q&A

Q1:AuriStream是什么?它与传统语音AI有什么区别?

A:AuriStream是MIT和斯坦福联合开发的生物启发语音AI系统。与传统语音AI不同,它模仿人类听觉系统的两阶段处理过程:先用WavCoch组件将声音转换成类似人类耳蜗的频谱表示,再用自回归模型预测声音序列。这种设计让它不仅能识别语音,还能理解词汇含义,甚至生成可解释的声音预测。

Q2:AuriStream在语音理解方面的表现如何?

A:AuriStream在多项测试中表现出色。在音素识别上达到88%准确率,接近最先进模型;在词汇语义理解方面创造了新纪录,得分12.52分,超过了之前最佳模型WavLM的10.50分。在SUPERB综合基准测试中,它在自动语音识别、意图分类等多个任务上都有竞争力表现。

Q3:AuriStream的可解释性体现在哪里?普通人能看懂吗?

A:AuriStream的独特之处是其预测结果可以转换成可视化的声谱图,就像看到声音的"图片"一样。研究人员演示了给系统播放单词开头,它能预测并"画出"后续声音的样子。比如给它"she"的开头"sh"音,它会预测出完整的"she"声谱图。这让我们能直观看到AI是如何"思考"声音的。