康涅狄格大学团队研发出一种全新图像传感器,通过计算而非镜头,实现高分辨率三维显微成像。

从射电望远镜描绘遥远星系,到显微镜观察活细胞内部结构,成像技术深刻改变了人类理解世界的方式。但在光学波段,一个长期存在的难题始终没有被解决。如何在不依赖复杂镜头、不需要极端精密对准的前提下,同时获得高分辨率和大视野的图像。

康涅狄格大学工程学院的一项新研究,给出了一个出人意料的答案。生物医学工程教授Guoan Zheng和他的团队在Nature Communications发表论文,介绍了一种全新的成像系统,可能重塑光学成像在科研、医疗和工业中的应用方式。

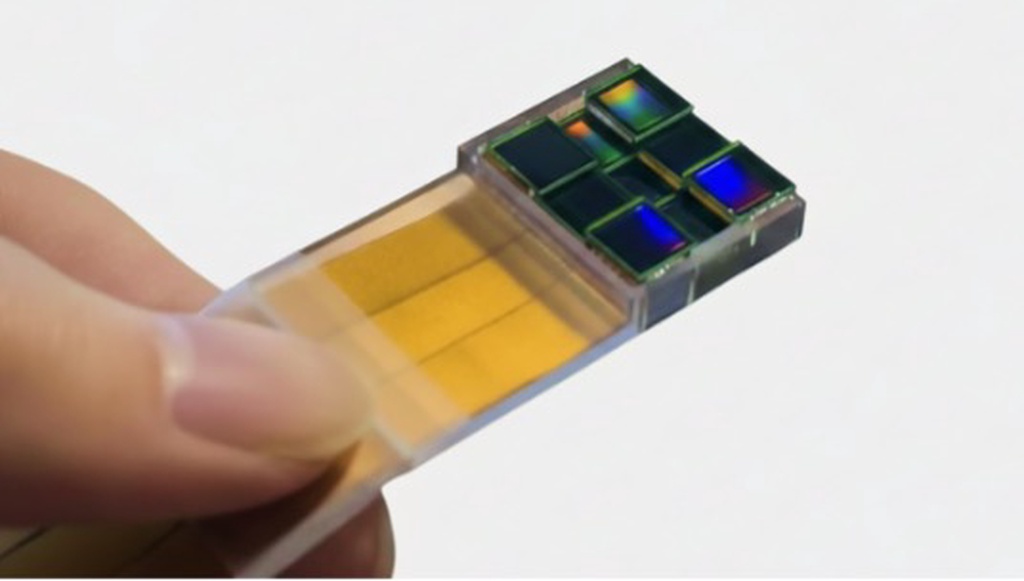

Guoan Zheng教授的实验室开发了一种新的图像传感器,可以在没有透镜的情况下实现光学超分辨率。受捕获第一张黑洞图像的望远镜阵列的启发,该设备使用多个传感器协同工作,通过计算合并它们的观测结果以查看更精细的细节。

问题的核心在于一种叫合成孔径成像的方法。这一方法曾被事件视界望远镜用来拍下黑洞照片。它的基本思路是,把多个分散的传感器采集到的数据进行相干合成,模拟出一个远大于单个设备的成像孔径。

在射电天文学中,这个方法可行,因为无线电波波长很长,不同传感器之间的同步要求相对宽松。但在可见光波段,波长缩小到微米甚至纳米级,要让多个光学传感器在物理层面保持完美同步,几乎不可能。

Zheng团队提出的多尺度孔径合成成像系统,简称MASI,彻底改变了思路。它不再强迫多个光学传感器进行纳米级同步,而是让每个传感器各自独立测量光信号,随后再通过计算方法在软件中完成同步。

Zheng的比喻很直观。这就像让多名摄影师同时拍同一个场景,但拍的不是普通照片,而是光波的原始信息。最后由计算机把这些独立的数据拼接成一张超高分辨率的图像。

这一计算相位同步方案,绕开了长期困扰光学合成孔径系统的硬件瓶颈,也让这种技术首次具备现实可行性。

MASI与传统光学成像在两个关键点上完全不同。首先,它不使用镜头来聚焦光线,而是在衍射平面不同位置放置一组带编码的传感器。每个传感器记录的不是图像本身,而是光与物体相互作用后形成的衍射图样。

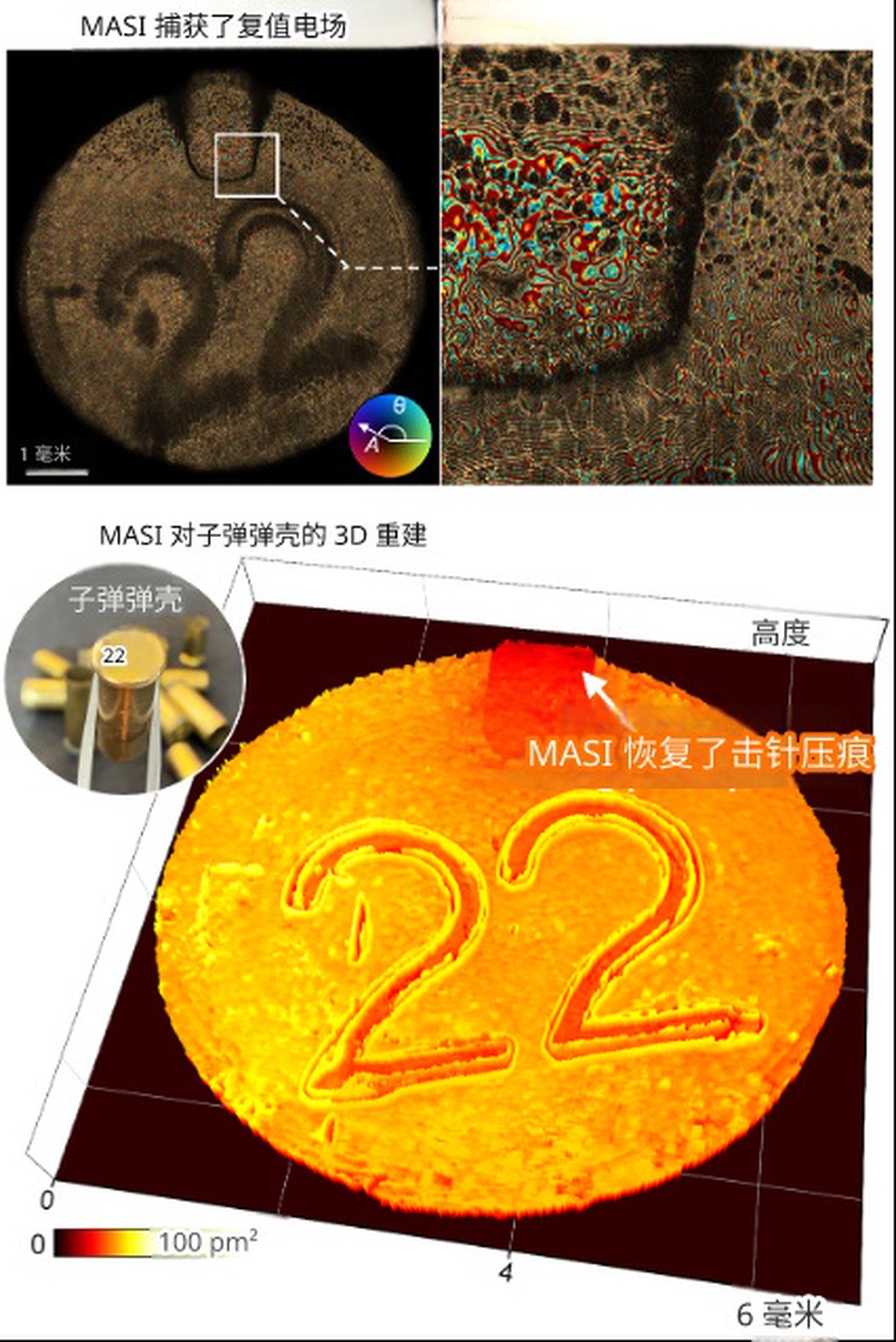

这些衍射数据包含光的振幅和相位信息,通过算法可以将其恢复出来。接下来,系统在计算中对每个传感器的波场进行补零和数值传播,把它们回溯到物体所在的平面。

真正的突破发生在相位同步这一步。算法会不断调整不同传感器数据之间的相对相位,让合成后的整体波场在能量和一致性上达到最优。同步不再依赖物理结构,而完全由软件完成。

MASI成像的子弹壳。上图:捕获的复电场包含振幅(亮度)和相位(颜色)信息。下图:这些数据能够以微米分辨率进行3D重建,显示撞针压痕,这是一种独特的标记,可以将子弹壳与特定的枪联系起来。

正是这一步,让MASI突破了衍射极限和传统光学的多重约束。最终效果相当于构建了一个虚拟的超大合成孔径,尺寸远超任何单一传感器,实现了亚微米级分辨率和大视野成像,而且完全不需要镜头。

在传统系统中,镜头始终迫使设计者做取舍。想看得更细,镜头就必须靠得更近,工作距离往往只有几毫米,这在很多应用中既不方便,也可能具有侵入性。

MASI彻底抛弃了镜头。它可以在厘米级距离外采集衍射图样,却重建出亚微米级细节。这相当于站在书桌另一端,就能看清一根头发上的细小纹路。

Zheng表示,这种成像方式的应用范围非常广,从法医分析、医学诊断,到工业检测和遥感探测都有潜力。更重要的是它的可扩展性。传统光学系统越做越大,复杂度会急剧上升,而MASI的规模扩展几乎是线性的。

多尺度孔径合成成像系统代表了一种新的成像范式。它用计算能力化解了物理光学的根本限制,让高分辨率、灵活、可扩展的成像成为可能。

本文译自 UConn Today,由 BALI 编辑发布。