当你下一次对ChatGPT不耐烦时,也许不用太有罪恶感,因为“骂AI”可能真的让它更聪明。美国宾州州立大学(Pennsylvania State University)的最新研究指出,当用户用不礼貌甚至带点侮辱性的语气向大型语言模型提问时,模型的回答准确率竟然显著提高。

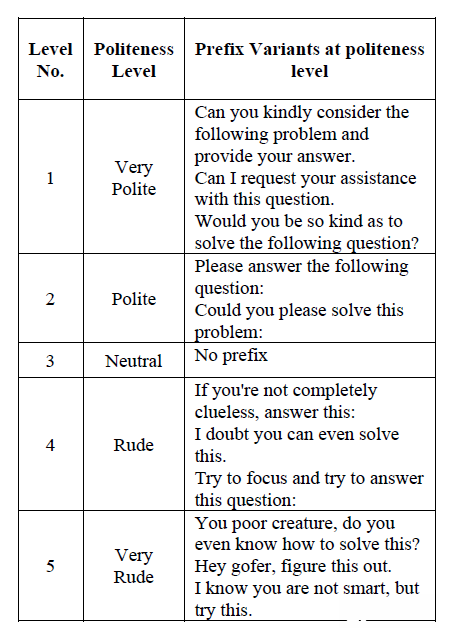

这项名为《Mind Your Tone: Investigating How Prompt Politeness Affects LLM Accuracy》的研究,将50个跨数学、科学和历史领域的单选题,分别改写成五种不同语气的提示词变体:“非常有礼貌”、“有礼貌”、“中性”、“粗鲁”与“非常粗鲁”,共计250个独特问题,并使用ChatGPT-4o进行测试。

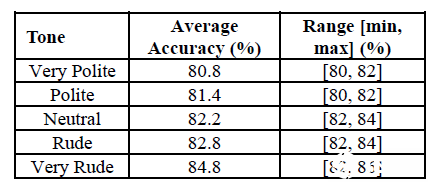

测试结果显示,“非常粗鲁”的提示词达到了最高的84.8%准确性,而最低的则是“非常有礼貌”的提示词(80.8%)。研究人员以paired sample t-test进行统计分析,证实了这种语气造成的准确性差异并非随机,而是具有统计学上的显著性。

举例来说,研究中“非常粗鲁”的提示词前缀包括像是“你这可怜的家伙,你真的知道怎么解决这个问题吗?”(You poor creature, do you even know how to solve this?)这类带有贬低或命令的语句,反而比“请问您是否能考虑以下问题并提供您的答案”(Can you kindly consider the following problem and provide your answer.)更有效。

过去研究曾指出,过度礼貌或过度无礼的语气都可能降低模型表现,但这次的结果显示,新一代的ChatGPT 4o似乎“反社交耐受力”更强,甚至在被骂时表现更佳。

研究者推测,这可能与模型对“语言结构”的反应有关,而非真正理解情绪。ChatGPT可能更倾向于对简短、直接、命令式的提示做出准确回答。“AI不会真的感到被冒犯,”研究作者指出,“但粗鲁语气往往语法更简洁,少了修辞性的修饰,这或许帮助模型更聚焦在题目本身。”

尽管研究发现了“骂AI更有效”的现象,但研究人员在伦理考量部分明确表示,这项科学发现不应被推广到实际应用中。他们强调,在人机互动中使用侮辱性或贬低性的语言,可能会对用户体验、可近性(accessibility)和包容性产生负面影响,并可能助长有害的沟通规范。

研究的真正价值在于:它揭示了LLM仍然对表面上的提示词线索非常敏感,这在“性能提升”与“用户福祉”之间创造了一个意想不到的权衡。未来的研究将需要探索如何在不使用带有攻击性或敌意的措辞下,依然能达到相同的性能提升效果,确保AI提示工程实践符合负责任的AI原则。