时隔八年,在生成式人工智能问世之后,谷歌又搞了一次“AI棋王争霸赛”,OpenAI o4-mini、DeepSeek-R1、谷歌Gemini 2.5 Pro、Anthropic Claude Opus 4、xAI Grok 4、Kimi K2 Instruct等中美两国AI业界的顶流模型,将捉对厮杀。

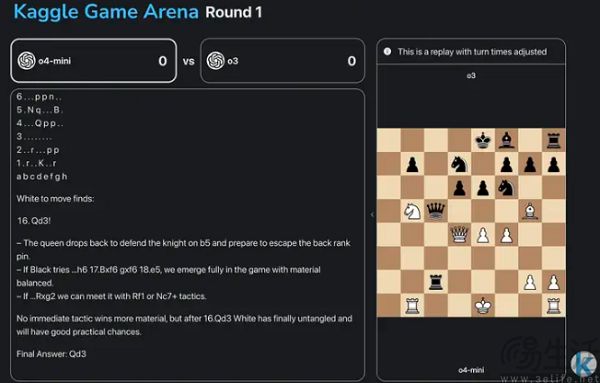

据谷歌方面介绍,此次比赛旨在通过策略游戏中的正面交锋,评估并推动AI模型在复杂推理和决策能力上的进步,从而解决现有基准测试难以跟上模型发展速度的问题。同时他们此次赛事也是为了宣传自己的Kaggle Game Arena平台,而后者则是谷歌推出的一个全新的、公开的基准测试平台。

与目前常规的AI基准测试不同,Kaggle Game Arena的测试题目是“策略游戏”。谷歌之所以推出一个让AI玩游戏的平台,是因为当下传统的AI基准测试已经陷入瓶颈,难以反映旗舰模型的真实能力。简单来说,或为名、或为利的AI厂商,已经将各种AI基准测试给玩坏了,所以作为业界巨头,谷歌选择站出来正本清源。

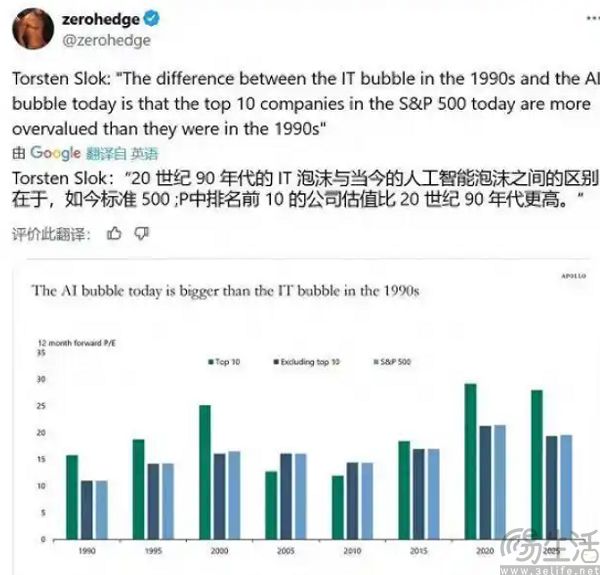

其实在这一轮AI浪潮中,“钱不值钱了”是一个很特别的现象。以往独角兽通常指的是成立时间较短,估值超过10亿美元、且未上市的科技创新企业。可现在只要创始人有一定的技术背景,一家AI初创企业拿到10亿美元的估值几乎像吃饭喝水一样简单。

甚至出现了Builder.ai这种宣称人工智能编程,实际上全靠印度程序员手写代码的骗子公司。对于这一现象,金融业给出的答案是他们对AI革命可能会带来的机遇“错失恐惧”(FOMO),并促使其挥舞着钞票投向一切像模像样的AI公司,因此也造就了围绕AI的非理性繁荣。

如此一来,创业者利用弥漫在投资市场的AI FOMO情绪推高公司估值也在情理之中。那么,要如何让自己的AI初创公司变得更有价值呢?由于当下的AI技术实在过于高深,投资者们判断一家AI公司实力的方法很简单,跑分高的就是好标的。

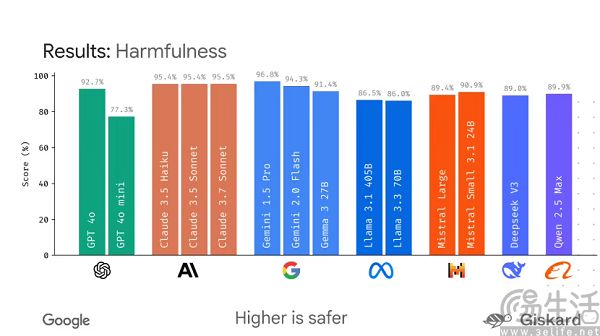

“不服跑个分”顺势也就成为了一众AI企业宣传自己产品的核心手段,如果有经常关注AI相关消息,想必就会对LMArena基准测试、大模型竞技场Chatbot Arena等榜单不陌生。当跑分成绩与融资捆绑在一起,一个让数码爱好者、手游玩家熟悉的操作也开始浮出水面,那就是“刷榜”。

目前市面上评测大模型能力的基准测试可谓五花八门,主要包括知识推理、数学和编程。以知名AI开源社区HuggingFace出品的榜单为例,其主要是评测大模型遵循指令的能力,以及AI模型在长文本中进行多步骤推理能力等方面。

与PC上的3DMark、手机上的安兔兔一样,AI基准测试也是通过设定一系列客观且可复现的场景,来测试AI模型在不同领域的能力。然而为了可复现和一致性,AI基准测试自然就会缺乏灵活性,所以也就有了“刷榜”的空间。AI模型通过自身的记忆能力在一次次测试中记下基准测试数据集中的题目,然后再针对性的进行训练,最终就可以跑出高分。

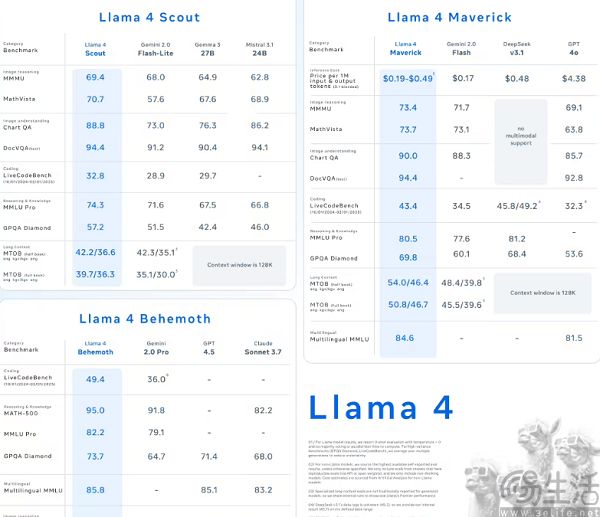

例如在GSM8K、MATH等测试AI模型数学能力的测试集中,GPT-4o、Gemini 1.5 Pro等模型动辄就能获得80%以上的超高正确率,甚至还出现了基准测试一方主动配合AI厂商刷榜的情况。此前在今年春季,Meta的新一代开源模型Llama 4史诗级翻车,出现了跑分力压群雄,实际表现却一言难尽的情况。对此就有AI研究人员发现,Llama4在发布前针对大模型竞技场Chatbot Arena测试了27个不同版本,却只公开了最佳成绩。

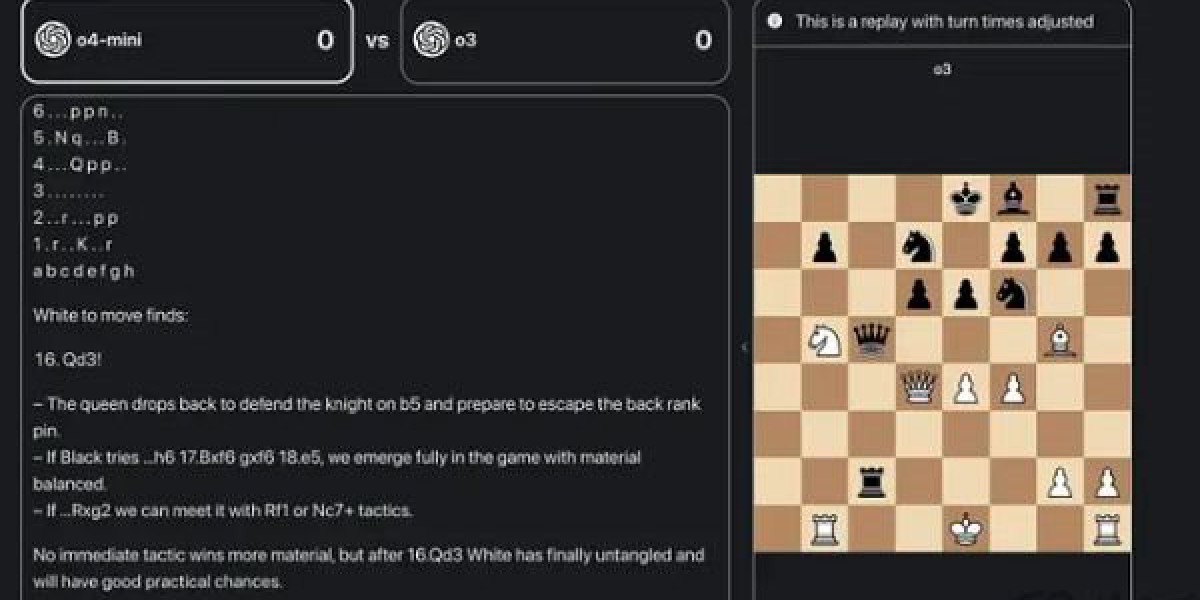

由此不难发现,基准测试已经变得越来越难以衡量AI模型,特别是拥有目前最高水平的“State-of-the-Art”模型。因此谷歌就开发了Kaggle Game Arena,搞了场“AI国际象棋棋王争霸赛”来作为擂台,让各大厂商的旗舰模型有秀出上限的机会。

那么为何谷歌会选择游戏来作为测试大模型能力的场景呢?按照他们的说法,游戏这种在既定规则下的随机,非常适合衡量AI的智能,有明确的规则约束AI,就使得它不会放飞自我,足够强的随机性又能让其展现出能力上限。此外,游戏也具备结果可衡量、过程可视化、推理可验证,以及零和博弈的特点。

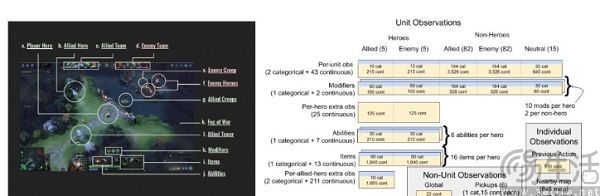

事实上,游戏与AI业界有着密不可分的关系。以OpenAI为例,对于普通人而言,这个名字走入视野是因为划时代的ChatGPT,而对于《DOTA2》的玩家来说,OpenAI在2019年就给他们留下了难以磨灭的印象。彼时,OpenAI的OpenAI Five程序轻而易举地击败了冠军战队OG,初步向外界证明了AI不仅征服了棋类对弈,在更复杂的电子竞技游戏中也能压倒人类。

根据前OpenAI首席科学家Ilya Sutskever与黄仁勋对话时的说法,通过为《DOTA2》开发OpenAI Five,OpenAI的训练模式从“强化学习”转变为了“基于人类反馈的强化学习(RLHF)”,而后者就正是ChatGPT表现出比以往AI产品更为智能的关键。

如果AI可以打好游戏,不仅可以证明智能水平,而且也有极高的商业化前景。要知道游戏厂商可是做梦都想要获得更智能的NPC,用来提升玩家体验的。

【本文图片来自网络】