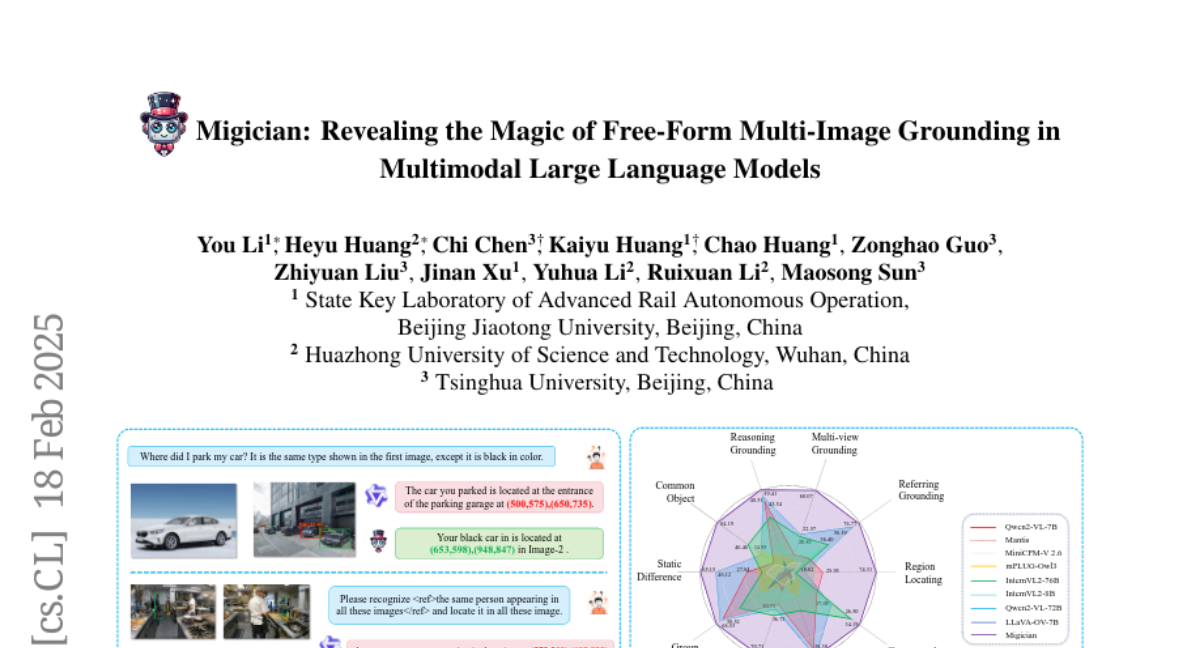

这项由北京交通大学、华中科技大学和清华大学联合开展的研究发表于2025年2月,研究论文可以通过arXiv:2501.05767v3访问。该研究首次提出了名为Migician的多图像视觉定位模型,这是一个真正的突破性进展,因为它让AI第一次具备了在多张图片中进行灵活定位的能力。

我们每天都在不知不觉中使用多图像定位能力。当你在停车场找车时,你会记住车的样子,然后在密密麻麻的车群中准确找到它的位置。当你看监控录像追踪某个人的行踪时,你能在不同角度的画面中识别出同一个人。这些看似简单的任务,对于AI来说却异常困难。

传统的AI视觉模型就像一个只能处理单张照片的"近视眼",它们在单张图片中找东西很厉害,也能理解多张图片的内容,但就是无法把这两种能力结合起来。这就好比一个人既是出色的侦探,又是优秀的档案管理员,但偏偏不能同时发挥两种技能去破案。

研究团队面临的核心挑战是:如何让AI在面对多张图片时,既能理解图片之间的关系,又能精确定位目标物体的具体位置。这个问题的难度在于,AI需要在理解"整体故事"的同时,还要有"放大镜"般的精确定位能力。

为了解决这个问题,研究团队首先尝试了一种叫做"思维链"的方法,就像让AI先用语言描述要找的东西,然后再去定位。这种方法有点像你先告诉朋友"我要找一辆白色的小汽车",然后朋友再去停车场帮你找。这个方法在简单情况下效果不错,但遇到复杂场景时就力不从心了,比如要找的不是具体的物体,而是一种抽象的概念或关系。

意识到这个问题后,研究团队开发了Migician模型。这个名字很有意思,结合了"多图像"(Multi-Image)和"魔法师"(Magician)的含义,寓意着这个AI能像魔法师一样在多张图片中"变出"目标物体的精确位置。

Migician的训练过程就像培养一个全能侦探。研究团队为它准备了一个包含63万个训练样本的巨大数据库,这些样本涵盖了各种多图像定位任务。就好比给侦探提供了63万个不同类型的案例,让他从中学会各种破案技巧。

整个训练过程分为两个阶段,就像培训一个侦探先学基础技能,再学高级技巧。第一阶段让Migician掌握基本的多图像理解和单图定位能力,就像让侦探先学会观察现场和分析线索。第二阶段则是让它学会处理更复杂、更灵活的定位任务,就像让侦探学会处理各种疑难杂案。

为了验证Migician的能力,研究团队还专门构建了一个全面的测试平台MIG-Bench,包含10种不同类型的多图像定位任务,总共有4300多个测试实例。这就像为侦探设计了一系列不同难度的考试,从简单的"找不同"到复杂的"跨图推理"都有。

在测试中,Migician的表现令人瞩目。它的平均准确率达到了63.82%,比第二名高出了近25个百分点。更令人惊讶的是,这个只有70亿参数的模型,竟然超过了许多拥有720亿参数的大型模型。这就好比一个轻量级拳击手击败了重量级选手,显示了技术优化的强大威力。

让我们来看看Migician能够处理哪些类型的任务。在"自发定位"类别中,它能够自主发现图片间的差异并准确定位。比如给它两张几乎相同的图片,它能自动找出不同之处并标出位置,就像玩"找茬游戏"的高手。它还能在多张图片中找到共同的物体,比如在一组照片中都有一只狗,它能在每张照片中准确标出狗的位置。

在"引用定位"类别中,Migician展现出了更高级的能力。当你用文字描述要找的东西时,它能在一组图片中找到正确的那张,并精确定位目标。比如你说"找一把电子秤",它能从多张无关图片中找到有电子秤的那张,并标出电子秤的位置。

更令人印象深刻的是,Migician还能处理视觉引用任务。你可以给它一张图片作为参考,它能在其他图片中找到相同或相似的物体。这就像你给朋友看一张车的照片,朋友就能在停车场中找到这辆车。

在一些需要推理的复杂任务中,Migician也表现出色。比如给它看一张人们在沙漠中缺水的图片,然后问它在另一张桌子的图片中,哪个物品能缓解第一张图中人们的困境,它能准确找到并定位水杯的位置。这种跨图推理能力,已经很接近人类的思维水平了。

研究团队还发现了一个有趣现象:训练Migician进行多图像定位,反而提升了它在单图像任务上的表现。这就像学会了团队协作的人,个人能力也会得到提升。在传统的单图像理解测试中,Migician不仅保持了原有水平,在某些方面甚至有所改进。

为了深入了解Migician的工作原理,研究团队进行了大量分析。他们发现,不同类型的训练数据对模型能力有不同的贡献。去除定位训练数据会显著降低多图像定位能力,这证明了专门训练的重要性。同时,他们还发现多任务学习比单独训练每个任务更有效,这说明不同任务之间存在相互促进的关系。

在处理不同难度任务时,Migician表现出了良好的鲁棒性。在简单任务中,它的准确率高达76%;在中等难度任务中仍能达到52%;即使在最困难的任务中,也有29%的准确率。这种性能分布很合理,符合人类学习和认知的规律。

研究团队还比较了不同的评估方法。他们发现,虽然让模型一次性输出所有答案在理论上更优雅,但逐个询问每张图片的方式在实际应用中更稳定可靠。这个发现对于实际部署很有价值,说明有时候稍微"笨拙"的方法反而更实用。

值得一提的是,Migician在一个特殊测试中表现出了意想不到的能力。研究人员将高分辨率图片分割成多个小块,然后让Migician在这些小块中找目标,结果它的表现堪比专门为此设计的系统。这说明多图像定位能力具有很强的泛化性,可以应用到原本不是为此设计的场景中。

这项研究的意义远不止于技术突破本身。在自动驾驶领域,Migician这样的技术能帮助车辆更好地理解复杂的交通环境,比如在多个摄像头的画面中追踪行人或车辆。在安防监控中,它能在多个监控点的录像中追踪嫌疑人的行踪。在医疗影像分析中,它能对比不同时期的扫描结果,帮助医生发现病情变化。

对于普通消费者,这项技术的应用前景同样广阔。未来的智能相册可能会变得更加智能,能够自动整理和标记照片中的人物和物品。购物应用可能会支持更精确的商品搜索,你只需要拍一张照片,就能在商城中找到相似的商品。家庭安防系统也可能变得更加智能,能够识别和追踪可疑行为。

当然,这项研究也面临一些挑战和限制。由于计算资源的限制,研究团队主要在较小规模的模型上验证了方法的有效性,在更大规模模型上的表现还需要进一步验证。另外,像所有AI系统一样,Migician有时也会产生错误的输出,这在实际应用中需要谨慎对待。

从技术发展的角度来看,这项研究为多模态人工智能的发展开辟了新的方向。它证明了将不同AI能力有机结合的可能性,为构建更加通用和智能的AI系统提供了思路。这种能力的结合不是简单的叠加,而是产生了新的、更强大的智能形态。

研究团队已经将Migician的代码、模型、数据集和测试平台全部开源,这意味着全世界的研究者都可以基于这项工作进行进一步的研究和改进。这种开放的态度有助于推动整个领域的快速发展,让更多人受益于这项技术。

说到底,Migician的成功不仅仅是一个技术突破,更是人工智能向人类认知能力迈进的重要一步。它让我们看到了AI在理解和处理复杂视觉信息方面的巨大潜力。虽然它还远没有达到人类的水平,但这种"举一反三"的能力已经让我们看到了通用人工智能的曙光。随着技术的不断发展和完善,我们有理由相信,未来的AI将能够在越来越多的领域为人类提供更智能、更精确的服务。

对于关注AI发展的读者,这项研究值得深入了解。完整的技术细节和实验结果可以通过访问论文原文获得,有兴趣的读者可以通过https://migician-vg.github.io/网站了解更多信息。

Q&A

Q1:Migician是什么?它和普通AI有什么不同?

A:Migician是由北京交通大学等机构开发的首个多图像视觉定位AI模型。与普通AI不同,它能同时理解多张图片的内容并精确定位目标物体位置,就像人类能在多张照片中找到特定物品一样。普通AI要么只能处理单张图片定位,要么只能理解多图内容但无法精确定位。

Q2:多图像定位技术在日常生活中有哪些实际用途?

A:这项技术应用前景很广泛。比如帮助自动驾驶汽车在多个摄像头画面中追踪行人,让安防系统在多个监控点追踪嫌疑人,让医生对比不同时期的扫描图像发现病情变化,让智能相册自动整理照片中的人物和物品,或者让购物应用通过照片精确找到相似商品。

Q3:Migician的准确率如何?比人类表现怎么样?

A:在测试中,Migician的平均准确率达到63.82%,比其他AI模型高出近25个百分点。虽然还远不如人类97.18%的表现,但这已经是AI在这个领域的重大突破。在简单任务中它能达到76%准确率,在困难任务中也有29%的准确率,显示出良好的适应性。